Buenas, he estado analizando muy por encima esos datos de techpowerup y me asaltan las siguientes incongruencias, a ver si alguien me lo explica porque no lo entiendo.

Vereis si nos fijamos en la pagina nº 5 "test set up" nos dice:

Todos los resultados de tarjeta de vídeo se obtienen en este sistema exacta con exactamente la misma configuración.

Todos los juegos se establecen en su posición más alta calidad a menos que se indique lo contrario.

AA y AF se aplican a través de ajustes en el juego, no a través del panel de control del conductor.

Bien partiendo de esa base y queriendo confiar en esta pagina que siempre me ha perecido seria, me surgen varias dudas sin investigar mucho... os cuento:

Si nos vamos al los testeos de "Assassin's Creed: Unity" y nos fijamos en los resultados de la 970 a 2560x1440 observamos que obtienen 19.5 fps de media y luego a 3840 x 2160 resulta que les da 20.1 fps al doble de resolucion ganan 1 fps WTF:roto2rie:

Pero ahi no acaba el tema:

Ahora nos vamos al los testeos de "The Witcher 3: Wild Hunt" y observo con sorpresa también que en la 970 por ejemplo a 1600 x 900 obtienen 43.5 fps a 1080p 38.4 a 1440p 29,3 y a 2160p 17.6 Eso, tomando como referencia lo que dice al principio es todo ultra y en este caso han especificado que es sin HairWorks habilitado para que sea mas neutro el resultado general ya que hay gpus amd, hasta aqui todo claro no? ok pues aqui vienen mi duda porque he perdido un tiempo en testearlo personalmente, os cuento. De 900p a 1080p con los citados parametros que ellos usan pierdo 25 fps, ellos solo bajan 5 fps de media. De 1080p a 1440p yo pierdo 35 fps, ellos solo bajan 9 fps de media y de 1440p a 2160p yo pierdo 36 fps mas y ellos solo bajan no llega a 12.... Esto lo he testeado personalmente en una 980ti que tiene mucho mas musculo que una 970. Alguien con una 970 podria probar en este caso el TW3 y confirmar si los datos de perdida de fps entre resoluciones son correctos en su review?

En cambio en otros testeos las perdidas por subida de resolucion se ajustan mucho mas a los que yo he obtenido es decir una perdida de unos 20 fps de 900p a 1080p otros 30 o de 1080p a 1440p y de 25 a 30fps de 1440p a 2160p que seria lo normal. No he querido seguir analizando todos los testeos restantes porque ya viendo esto no me fiaba.

Entonces yo me pregunto, como han hecho estos testeos? estaba sereno el que los hizo y los hizo de manera objetiva y rigurosa buscando ser imparcial o de lo contrario los hizo de manera negligente y con algo de desidia?... no lo se que juzgue cada uno lo que quiera, pero yo no me acabo de fiar...

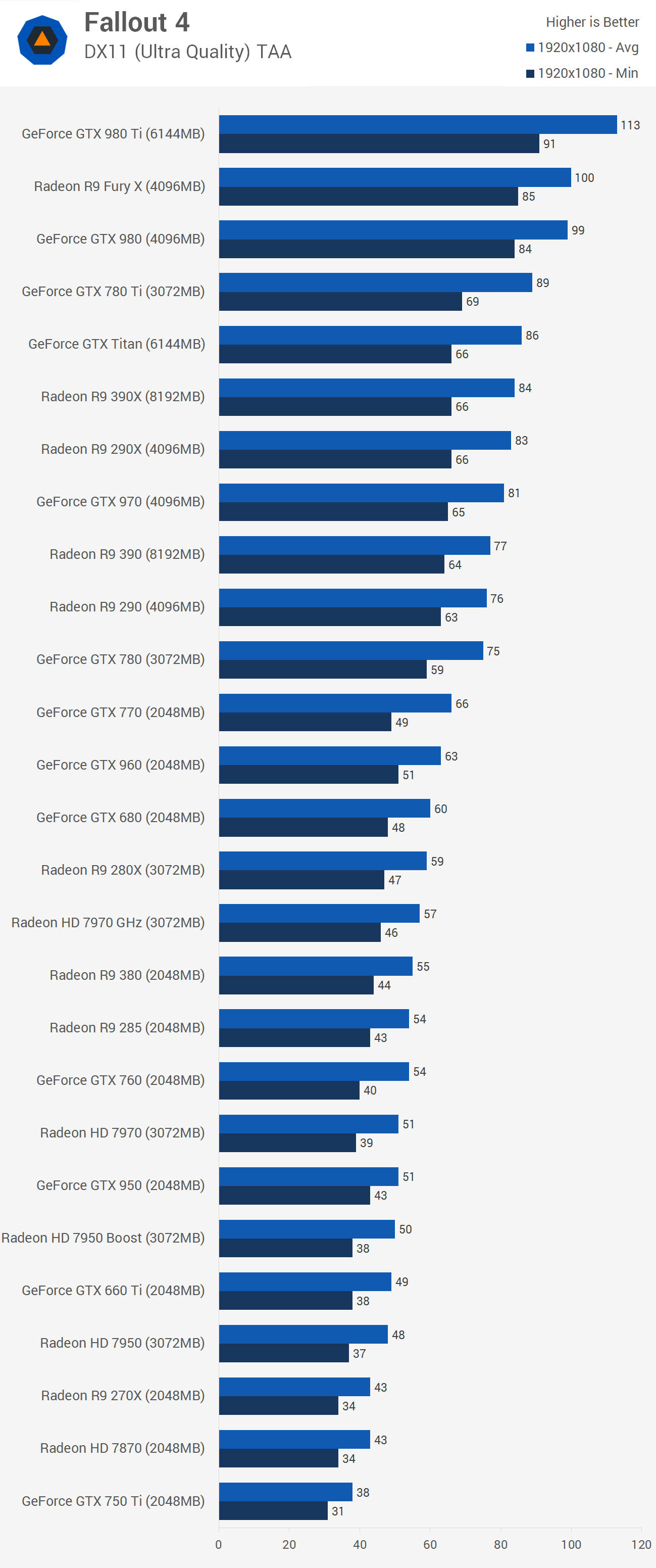

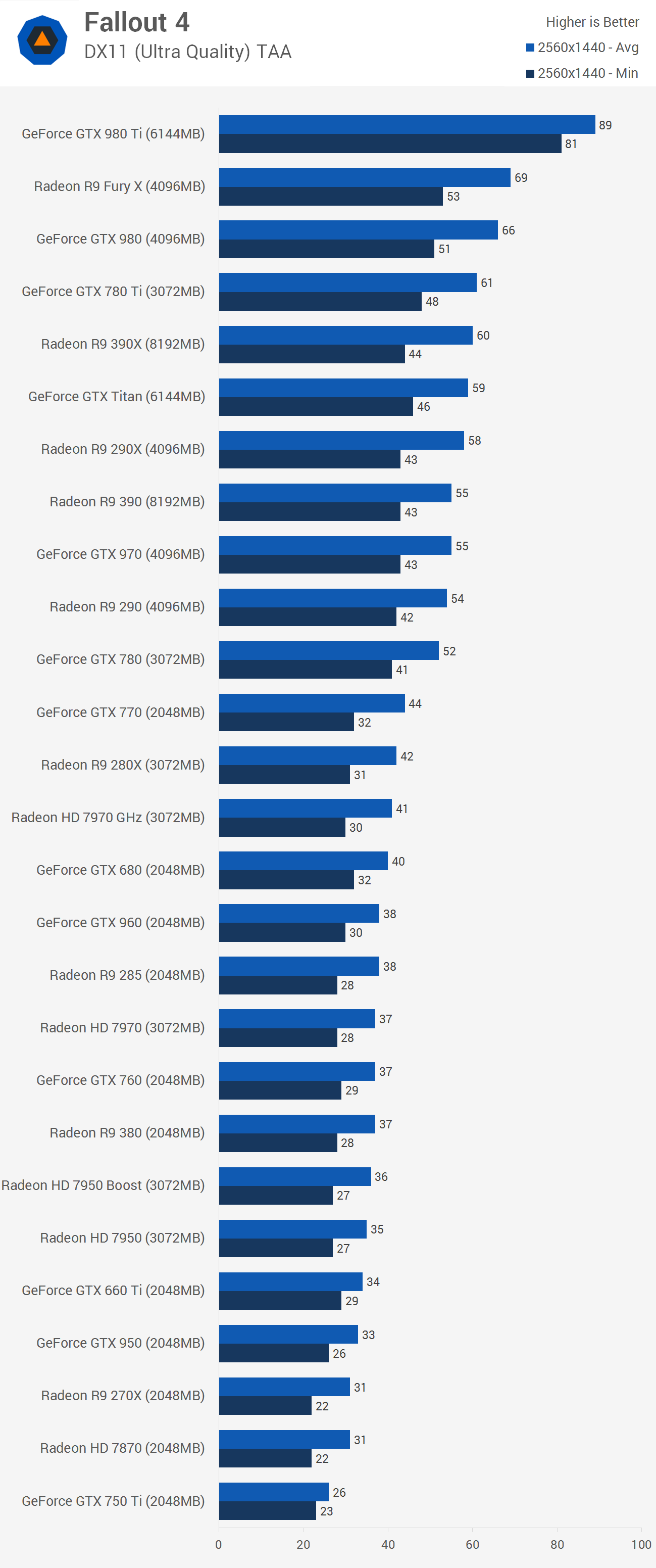

Sobre el rendimiento de la 390 vs 970, la que para mi sigue siendo la reina de 1080p cuando ambas van bien apretadas, hay diversos resultados segun la web y supongo que intereses que tengan de por medio... que no deberia pero pienso que los hay. Pues aqui os dejo otro enlace donde vemos que la 970 es superior a la 390 incluso a la 390x en la mayoria de casos a la resolucion que digo e incluso las supera en otras situaciones a resoluciones mayores.

https://www.youtube.com/watch?v=jatjGYaX2PU

Saludos y ya me direis vuestras opiniones.