Estás usando un navegador obsoleto. No se pueden mostrar este u otros sitios web correctamente.

Se debe actualizar o usar un navegador alternativo.

Se debe actualizar o usar un navegador alternativo.

[GUIA] ELECCION DE MONITOR: Dimensiones, resolucion y distancia

- Autor American Graffiti

- Fecha de inicio

TirsoTomas

Nuevo

- Registrado

- 5 May 2021

- Mensajes

- 2

- Puntos

- 1

- Edad

- 33

Excelente tutorial y bien detallado, me has ayudado a conocer aun más lo poco que sabia!

M

Mars_Gamer

Guest

Increible...

- Registrado

- 23 Abr 2018

- Mensajes

- 11.084

- Puntos

- 113

- Edad

- 42

Depenmde del modelo de monitor.Lo del freesync de AMD funciona con las gráficas de Nvidia?

Ya que su implementación es via Drivers.

Hoy en día, la gran mayoría de monitores actuales si que aceptan el G-Sync Compatible.

Saludos.

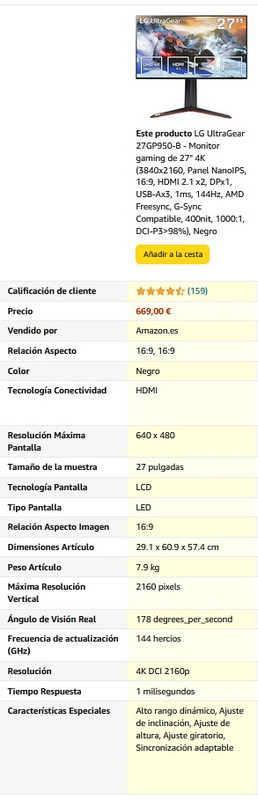

Hola. Estoy pensando en pillar un monitor para una PS5. He mirado unos cuantos pero en uno de ellos que he visto en Amazon hay algo que me llama la atención.

No sé si se aprecia en la captura pero especifica por un lado una resolución máxima de pantalla de 640X480 y por otro de una resolución 4K DCI 2160p. ¿No son dos cosas un tanto contradictorias?

Por si me lo podéis aclarar. Muchas gracias por adelantado.

No sé si se aprecia en la captura pero especifica por un lado una resolución máxima de pantalla de 640X480 y por otro de una resolución 4K DCI 2160p. ¿No son dos cosas un tanto contradictorias?

Por si me lo podéis aclarar. Muchas gracias por adelantado.

LuisCarlos

Nuevo

- Registrado

- 1 Ene 2023

- Mensajes

- 3

- Puntos

- 3

- Edad

- 20

Qué nivel de detalle y explicación, muy buena redacción y enhorabuena![GUIA] ELECCIÓN DE MONITOR: Escalado, reescalado, interpolación, multimedia, HDR, consolas y espacios de color

________________________________________________________________________________________________________________________________________________

Seguimos ampliando la guía con alguna de las dudas que veo que han ido saliendo, bien en este hilo, bien en otras consultas sobre monitores.

RESOLUCIÓN NATIVA, ESCALADO Y ANTIALIASING

La característica principal de toda pantalla (monitor, móvil, televisión...) es su resolución que es el recuento de pixels verticales y horizontales que contiene el panel. Sin embargo no siempre utilizamos una "fuente" (el contenido que enviamos a la pantalla) que tenga exactamente los mismos pixels que el panel, lo que le obliga a tener que realizar una "interpretación" de los pixels que le faltan o que le sobran.

- Resolución nativa: es el número de pixels horizontales y verticales que puede mostrar un monitor con un escalado 1:1 (1 píxel de imagen:1 píxel de pantalla). Es el modo "ideal" de usar una pantalla y nos asegura su correcta visualización.

- Upscaling/Downscaling: Significa jugar con la escala de resolución de una fuente (de vídeo normalmente) aumentando/reduciendo su resolución mediante interpolación, siendo unos términos relacionados con la edición de vídeo, por ejemplo para adaptar la calidad de un vídeo para subirlo a redes sociales a 720p por ejemplo. Es un término que no hace referencia a la resolución del monitor, sólo a la fuente, por lo que generalmente usaremos más los términos upsampling/downsampling.

- Upsampling/Downsampling: Significa utilizar una fuente (de vídeo normalmente) con una resolución inferior/superior a la resolución nativa de la pantalla, para que mediante interpolación veamos esa fuente "convertida" (o reescalada) a la resolución nativa de la pantalla. Por ejemplo ver un vídeo en 1080p en una televisión 4K sería upsampling, mientras que ver un vídeo 4K en una pantalla de 1080p sería downsampling. En ambos casos estaremos obligando a la pantalla a hacer un reescalado de la imagen mediante interpolación.

- Interpolación: Es un proceso matemático que permite la obtención de nuevos puntos partiendo de un conjunto discreto de puntos previo. En el caso de pasar de 1080p a 4K (upsampling) tienes que sacar 4 pixels de cada pixel previo, de forma que calcula valores medios de color con los puntos adyacentes para asignar a esos nuevos pixels. Es decir, nos inventamos pixels. Y en el caso contrario, de pasar de 4K a 1080p (downsampling) tiene que sustituir 4 puntos por un único pixels cuyo color será la media de esos 4 pixels.

- Aliasing/antialiasing: Debido a que las pantallas se componen de líneas verticales y horizontales, la representación de curvas y de líneas inclinadas produce un efecto de "diente de sierra" denominado aliasing. Los filtros antialiasing lo que hacen es interpolar los puntos adyacentes para suavizar dichos "dientes de sierra". Estos filtros se usan en diferentes sectores, pero fundamentalmente los veremos ligados al mundo del gaming. En juegos también es frecuente que la gente utilice el downsampling para obtener un resultado "paredico" al antialiasing, dando una sensación de mayor definición al eliminar el aliasing, incluso haciendo que se vea mejor con ese downsampling que con la resolución nativa y los filtros antialiasing.

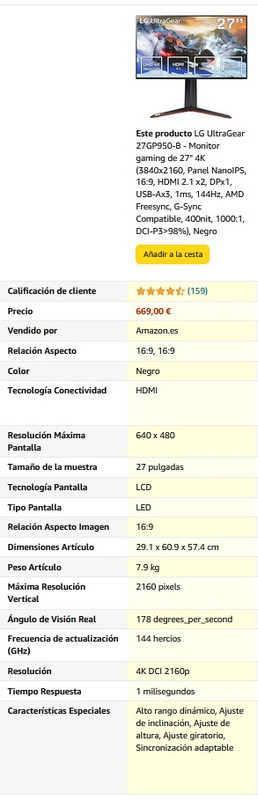

SpoilerEjemplo de interpolación de texto, por colaboración de @chetodann, en un monitor 1440p

Arriba texto a su resolución nativa 1440p, abajo, a 1080p en su misma relación 16:9. Como puedes observar se pierde nitidez al interpolar.

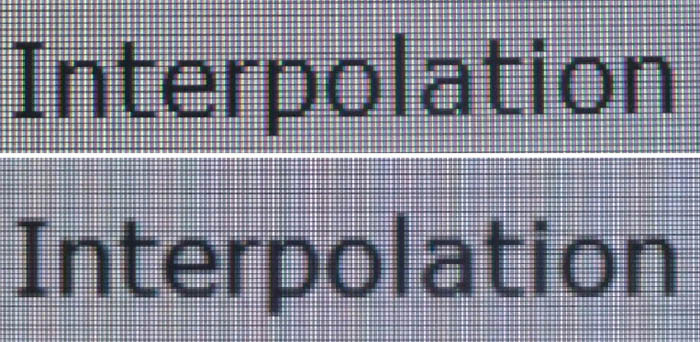

Ejemplo de uso de filtros Antialiasing

A la izquierda sin filtros, centro FXAA, derecha SSAO. Como podéis observar los dientes de sierra se suavizan y se percibe la imagen más nítida.

Ejemplo de Downsampling

A la izquierda vemos la imágen a 1080p, mientras en la derecha vemos el mismo encuadre, con la misma cantidad de pixels, pero que es un downsampling desde 5K (5120x2880). En la segunda se aprecia perfectamente la inscripción del arma (P90 cal 5.7x23) mientras que en la primera sólo vemos un borrón.

Con estos 5 conceptos tenemos ya más claro cómo funciona el tema del reescalado de imágenes. Es algo más teórico que otros de los puntos de la guía, pero resulta imprescindible para poder entender realmente lo que viene a continuación.

MULTIMEDIA, RESOLUCIONES DE VÍDEO, FORMATOS DE ARCHIVO, CODIFICACIÓN Y TAMAÑO DE ARCHIVO

Por otro lado, hay que aprender a ver que la resolución de vídeo no lo es todo, una misma película en 1080p puede pesar desde 1,4GB a 14GB. Si ya pasas a 4K esas diferencias se disparan aún más, superando los 60GB una película en muy muy buena calidad. ¿Dónde está la diferencia? Pues en el formato que se utilice y en los códecs de compresión (tanto de vídeo como de audio), desde el DivX al MKV, pasando por todo tipo de ripeos de calidades variopintas. ¿Cómo es posible? Pues porque tenemos un producto más comprimido y que ha perdido gran parte de esa información, por eso en las escenas oscuras se suelen notar los escalones en la escala de grises (posterización), en vez de ser algo más progresivo.

Estamos acostumbrados a manejar formatos de audio/imagen/vídeo "comprimidos" como son mp3 en música, jpg, png y tiff en imágenes o avi, mpg o mkv en vídeo. Sin embargo cuando alguien hace una fotografía o vídeo profesional la hace en "formato RAW" (significa crudo, sin modificar), luego las procesa y el resultado lo saca de forma más comprimida en los formatos que hemos comentado. En ese proceso de compresión se pierde información, por ejemplo eliminando las frecuencias que no tienen sonido en audio, reduciendo los bits de color en imágen o ajustando los fps de grabación a los 24-30Hz que vemos en la tele; dando como resultado archivos mucho más manejables a costa de sacrificar calidad.

De hecho esto que parece que es cosa de "profesionales" lo hacemos nosotros a diario. Cuando grabas un vídeo con tu cámara de acción a 1080p@60fps el resultado es un archivo masivo, que puede superar 1GB por cada 5min de vídeo, algo que difícilmente vas a poder pasar a tus amigos. Pero es que cuando grabas un vídeo o haces una foto desde el móvil y la envías por Whatsapp, también estás comprimiéndola para que esta sea más fácil de enviar y de recibir, pasando ese vídeo de 5min que pesaba 1GB de forma que sólo pese 20-30MB.

Dependiendo de la resolución, del formato utilizado y de los codecs (que serían las bibliotecas de órdenes de compresión) podemos tener como resultado archivos con tamaños tan dispares como los que hemos comentado al principio.

- Si la fuente de vídeo es de buena calidad, aunque la resolución no sea la nativa de la pantalla (por ejemplo 720p>>1080p ó 1080p>>4K) el resultado de ese upsampling será mucho mejor que si partimos de una fuente de vídeo más comprimida. Incluso es posible que el resultado sea mejor que una fuente de menor calidad pero que sí sea de la resolución nativa de la pantalla. Es posible que notes algo de aliasing, pero sin embargo no tendrás casi posterización.

- Para el caso de un monitor 1440p, la diferencia de que la fuente varíe la resolución entre el 720p/1080p se nota incluso más que entre 1080p/1440p. El aliasing de pasar de 720p a 1440p se hace muy evidente, viéndose los contornos de las figuras muy poco definidos. ¿Por qué al pasar de 1080p a 4K eso no se nota tanto, si en ambos casos multiplica la resolución x2? Pues porque los monitores 4K tienen unas densidades de pixels muy altas y las televisiones 4K las vemos a una distancia superior a la óptima.

- Y en cualquier caso, siempre la distancia de visionado va a influir en cuál sea tu percepción sobre todo esto. Cuanto mayor sea la distancia menos capaz serás de diferenciar entre las diferentes resoluciones.

En el primer post de esta guía hemos estado hablando de las distancias de visionado y cómo hay unas distancias "límite" para percibir las diferencias de resolución. Como véis ahora esto no es una ciencia exacta... pues el downsampling te permite "emular" una resolución mayor (ficticia) y lograr una mejora de nitidez de imagen (que es real y la percibes).

HDR, CANDELAS Y NITS

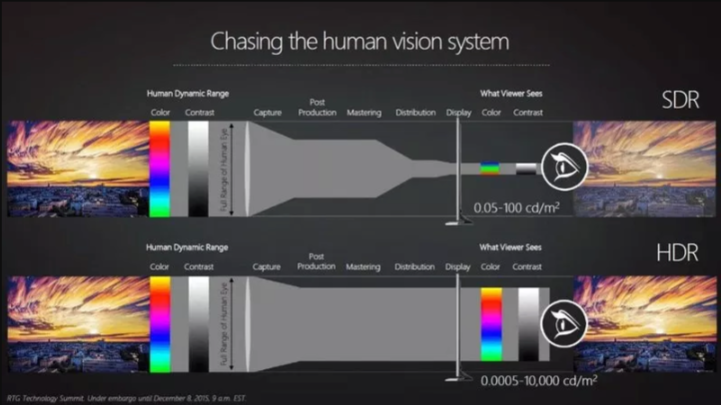

Llevamos unos años bastante familiarizados con el término HDR y empezamos a encontrarlo por todas partes (cámaras de fotos, televisiones, consolas, móviles, monitores...) pero muchas veces no tenemos muy claro qué expresan realmente esas iniciales. En principio voy a hacer un repaso más o menos rápido, para aquellos que realmente estén muy interesados en el tema, les aconsejo pasar por el hilo HDR (High Dynamic Range)

HDR (High Dynamic Range) que traducido al español es Alto Rango Dinámico es una técnica de procesado fotográfico que busca combinar varias fotos con diferentes exposiciones para lograr una foto que tenga un mayor rango de color. En realidad es algo que nosotros hacemos de forma natural al mezclar las imágenes que obtenemos de los 2 ojos uniéndose en una única imagen en nuestra cabeza, lo que nos permite diferenciar detalles tanto en zonas oscuras como en otras iluminadas al mismo tiempo.

**En la foto de la izquierda vemos como casi no somos capaces de sacar detalle de las zonas en sombra, mientras que en la derecha (HDR) podemos ver muchos más matices, tanto en las zonas en sombra, como en el cielo y el sol que antes aparecían quemados.

Pues bien ese HDR (que hemos explicado en fotografía) con el tiempo ha dado el salto al soporte vídeo y el siguiente paso fué el hacer pantallas capaces de representar ese HDR con precisión. Sin embargo nos encontramos con un primer problema de cantidad de brillo:

Es decir para tener una experiencia HDR real necesitamos una cantidad de brillo y contraste (brillo de 1000 nits y contraste 5000:1) muy superior a la que ofrecen nuestros monitores actuales (brillo de 250~350 nits y contraste 3000~1000:1). Además conllevaría mejorar la uniformidad de la iluminación de los paneles, que éstos fueran de 10bits de color (mínimo) y manejar un espacio de color (DCI-P3) más amplio que el habitual sRGB (en la siguiente sección comentaré los diferentes espacios de color). *** ( 1nit = 1cd/m²)

Para unificar un poco los requerimientos del HDR han surgido varios estándares, pero los principales son HDR10 y DolbyVision.

- HDR10: es el estándar más extendido y requiere de 1000nits y 10bits de color.

- DolbyVision: es un estándar que empiezan a alcanzar las TV de alta gama, exigiendo más de 1000nits y 12bits de color.

Pero como veíamos al principio, la gran mayoría de monitores están lejos de alcanzar esos 1000nits y 10bits. Sin embargo tenemos ya algunos monitores que empiezan a utilizar la coletilla HDR sin llegar a alcanzar esos estándares, pudiendo denominarlos pseudo-HDR:

- Dell HDR: Supuestamente son monitores con un brillo de 450-550nits y 10bits de color, compatibles con contenidos HDR10. Y digo supuestamente porque tienen algunos modelos con 250-300nits, ojo con eso.

- BenQ HDR: También andan manejando cantidades entorno a los 400nits y con soporte HDR10 y DCI-P3 (~90%). Sin embargo algunos de estos monitores son 8bits o no alcanzan esos 400nits, ojito también.

- Samsung QuantumDots: Son paneles con una capa denominada Quantum Dots que mejoran el contraste y superan el 125% sRGB (cuando el resto de monitores VA se quedan en el 95-100%). Son monitores muy coloridos, pese a quedarse en unos 350nits. Samsung no los denomina HDR, pero sí los marca como "HDR Support".

- LG HDR PC: Otro fabricante que da soporte a HDR10 pero que no llega a alcanzar sus mínimos, se queda en los 350nits y 10bits (8bit+FRC). Como curiosidad incluye un modo "HDR Effect" para simular el HDR en contenidos que no sean HDR.

- Seguro se me olvida alguno... ya completaré.

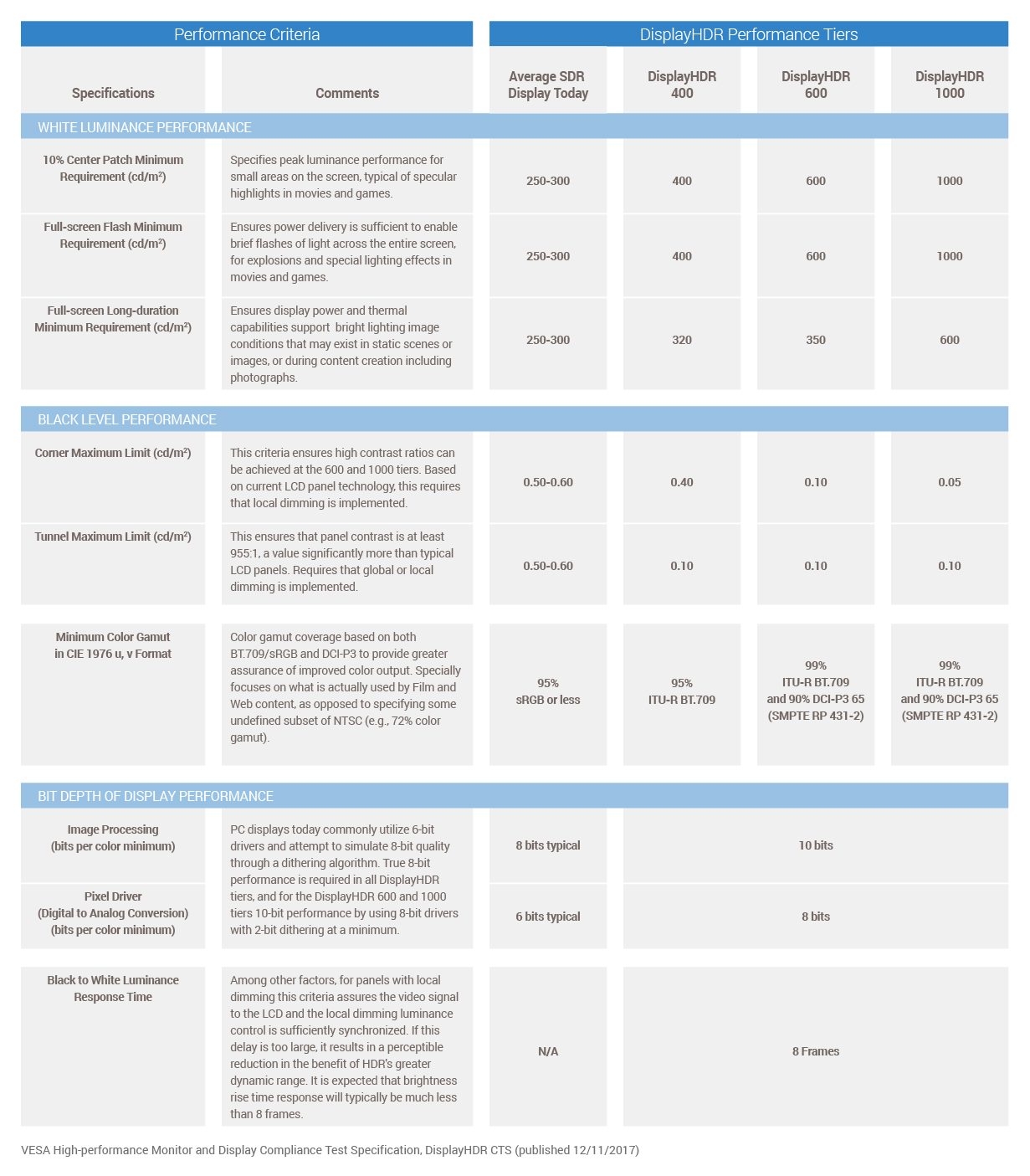

Criterios VESA y los certificados HDR400 / HDR600 / HDR1000

Como vemos los monitores actuales quedan lejos de alcanzar los criterios del HDR10 y DolvyVision. Por eso VESA (Video Electronic Standards Association) ha creado una serie de etiquetas/certificados para "monitores HDR" (pseudo-HDR) que se pueden consultar en esta web >> Performance Criteria - Vesa Certified DisplayHDR™

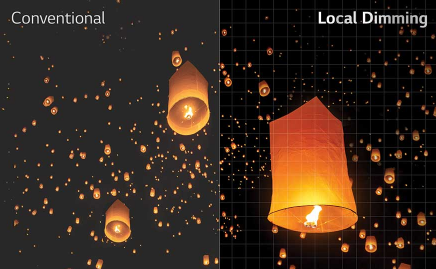

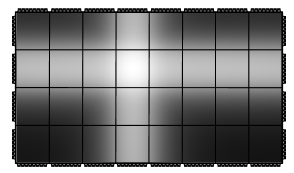

Como vemos en la tabla, establecen limitaciones referidas a la luminancia (cd/m²), a los niveles de negros y al espacio de color (gamut y bits de color). Exigencias que siendo inferiores a las de HDR10 les siguen quedando grandes a la mayoría de monitores y aunque ya se empiezan a ver los primeros monitores con HDR400 (e incluso HDR600) ya avisan en la tabla que para alcanzar los valores de HDR600/HDR1000 tenemos que irnos a monitores con local dimming (es decir que sean capaces de apagar/encender/atenuar dinámicamente los leds de retroiliminación de la pantalla, no sólo "oscurecerlos" en la capa LCD)

MONITORES, HDR y CONSOLAS

Desde hace tiempo empieza a ser habitual que la gente quiera comprar un monitor para jugar a la consola, bien por manejar unas dimensiones reducidas, bien porque buscan unos tiempos de respuesta que las TV no son capaces de ofrecer, bien porque juegan tanto al PC como a la consola y quieren tener una única pantalla.

Ahora mismo nos encontramos en una situación de doble generación consolil, tenemos las PS4 y Xbox One que funcionan a 1080p y las PS4 Pro y Xbox One X que funcionan hasta 4K+HDR. Por el tipo de contenidos que vamos a consumir en las consolas (80-90% juegos / 10-20% multimedia) lo ideal es ir a por un panel VA que nos dará mayor contraste y colores más vivos, pudiendo ir a por un IPS en caso de que juguemos acompañados (por los mejores ángulos de visión). Los TN en principio los descartaría.

En principio las consolas sólo sacan formato 16:9, mucho ojo con esto, sobretodo si alguno tenía pensado coger un Ultrawide. No es que no vaya a funcionar, pero tendrás que elegir entre tener franjas negras a los lados o ajustarlo al ancho y perder algo de imagen arriba y abajo (o que la imagen quede achatada según el modo que pongamos en la pantalla).

En cuanto a resolución TODAS son capaces de manejarse desde los 720p a los 2160p (4K).

- PS4 y Xbox One sólo alcanzan los 1080p (FHD), por lo que en pantallas de mayor resolución veremos un 1080p reescalado.*

- PS4 Pro y Xbox OneX alcanzan los 2160p (4K) nativos. Sin embargo el soporte a 1440p (2K) nativo depende de que haya sido implementado (o no) por el desarrollador del juego*. De no ser así será un 1080p reescalado.

Respecto al HDR tanto PS4 Pro como Xbox OneX tiene soporte para HDR10. Pero como hemos visto en el punto anterior hay pocos monitores que cumplan ese HDR10, sin embargo debería poder funcionar el HDR en cualquiera de los monitores con "soporte HDR10" que hemos comentado en el apartado de HDR, con independencia de si son 1080p, 1440p o 2160p.

* Se supone que todas las Xbox One tienen desde primavera de 2018 soporte nativo para 1440p.

** En Xbox hay todo un jaleo de resoluciones nativas de los propios juegos, algunos tienen soporte nativo 2160p (4K), otros sacan un 1760p y desde ahí reescalan a 2160p (4K), mientras otros van a 1440p (como hemos dicho tiene soporte nativo ya) y de ahí reescalan a 2160p. Por su parte PS4/PS4Pro sólo considera las salidas a 720p/1080p/2160p de modo que a 1440p funcionará como reescalado a 1440p por más que la consola utilice esa resolución internamente para renderizar juegos que luego reescala a 4K.

*** No soy experto ni mucho menos en consolas, tengo una PS4 Slim que se pasan meses entre cada uso. Si os interesa el tema investigar un poco más respecto a vuestra consola.

Consolas y compatibilidad con la tecnología FreeSync

Es conocido que AMD es quien fabrica las "tripas" de la actual generación de consolas Xbox y PS (incluidas sus versiones "Pro"). Y el hecho es que esas "tripas" tecnológicamente son compatibles con FreeSync (algo que ha pasado bastante desapercibido para la mayoría). En el caso de Sony (PS4 y PS4 Pro) no ha habilitado dicha compatibilidad... mientras que Microsoft ha visto la oportunidad y sí da soporte para FreeSync en sus consolas (Xbox One S y Xbox One X). Eso sí, para tener compatibilidad debes tener un monitor (o TV) con FreeSync mediante HDMI (por HDMI 2.0 si quieres usarlo en 4K con FreeSync).

Para activarlo en tu Xbox tienes que ser "insider" y en el apartado vídeo del a consola tienes que activar el la opción de "tasa de refresco variable" (o algo parecido se llama) y ya está, no tienes que hacer más (bueno sí... activar el FreeSync en el monitor).

*** En cualquier caso, antes de comprar un monitor, busca en Google si alguien ha probado dicha compatibilidad con la consola.... así evitarás posibles desilusiones por haber comprado un monitor que luego no es compatible.

Consolas y 10bits de color

Las consolas PS4 Pro y Xbox One X están preparadas para funcionar en 4K y además aprovechar el estándar HDR10 (10bits y 1000nits). Lamentablemente no hay monitores HDR10 reales (todavía) entre otras cosas porque el brillo de los monitores suele rondar los 250-400 nits (1nit = 1cd/m²). Sin embargo sí hay monitores de 10bit de color y sí hay monitores con "compatibilidad" con contenidos HDR10. ¿Tengo que hacer algo para aprovechar esos 10bits de color? (en el apartado siguiente explicamos las diferencias entre espacios de 8bits y 10bits)

Supuestamente no tienes que hacer nada... tan sólo conectar tu consola PS4 Pro o Xbox One X con un HDMI 2.0 a un monitor con 10bits y HDMI 2.0 (no sé qué tan bien puede funcionar con adaptadores HDMI 2.0 a DP). Así que aseguraté de que cumple ésto cuando vayas a comprar un monitor para tu consola.

Resumiendo... si buscas un monitor para consolas (además de los criterios de distancia/resolución) vemos que preferiblemente que tenga FreeSync (aunque tu consola actual no lo aproveche, seguramente la siguiente que compres sí lo haga), mejor que tenga un panel de 10bits nativo (supongo que 8bit+FRC vale también) y si tiene función HDR posiblemente la vas a poder aprovechar (algo que en PC de momento se aprovecha menos). Adicionalmente si tienes una Xbox One S (o One X) y no quieres irte a un monitor 4K, puedes ir a por un monitor 1440p ya que tienen soporte nativo.

ESPACIOS DE COLOR, BITS, QUANTUM DOTS (QLED) y NanoIPS

Podríamos irnos mucho por las ramas si empezamos a explicar esto desde el principio (en plan Sheldon Cooper) empezando por la teoría de color y la colorimetría... Voy a intentar explicarlo con ejemplos fáciles.

Esos tres (sRGB, Adobe RGB, NTSC) son sólo algunos de los espacios de color existentes en los ordenadores, pero no son los únicos, hay otros como ProPhoto RGB, CMYK (esto sería para plotters), YCbCr (para compresión de vídeo), HSV, HSL, Apple RGB, ColorMatch RGB... Los colores en las pantallas son "aditivos" pues se forman mezclando rojo/azul/verde y los diferentes espacios hacen referencia a diferentes formas de mezclar los colores y todo el abanico de colores que podrías sacar en el mismo. Pero ¿qué diantres es un espacio de color?

Pues imagina cuando estabas en el colegio y tenías la mítica caja de lápices de colores "Alpino" de 8 colores, siendo 3 verdosos, 3 rojizos y 2 azulados. Pues mezclando los colores de podrás sacar una serie de colores (2^8) que darían un total de 256 colores. Bien, pues eso básicamente es un espacio de color de 8bits como tenían los ordenadores de hace 25 años. Sin embargo llegaba un amigo con una caja más grande, de 16 lápices, con 5 verdosos, 5 rojizos, 5 azulados y 1 blanco, que mezclándolos podía sacar colores que tú no podías reproducir (2^16) sacando un total de 65.536 colores. Vale esto sería un espacio de color de 16bits o High Color. Al año siguiente llegaba otro compañero con una caja aún más grande, de 24 lápices, sacando (2^24) 16.777.216 de colores, pudiendo pintar con eso cualquier cosa. Ok, esto sería un espacio de 24bits. Y así podríamos seguir explicando las cajas de 36 y 48 lapiceros (36 y 48 bits).

Sin embargo, llegó un niño raro de fuera, que no usaba Alpino sino Faber Caster de 24 lápices comprados en Japón por su tío y resulta que teniendo el mismo número de lápices (y por tanto sacando los mismos colores) estos no eran exáctamente iguales, su azul clarito era diferente del tuyo y su verde molaba mucho más. Es decir, el espacio de color "Alpino" no coincidía con el espacio de color "Faber Caster" pese a que los dos eran de 24bits.

Bueno pues ahora ya entendemos más o menos de que va el tema, así de forma simplificada. De modo que veamos la imagen

Ahí tenemos un gráfico con algunos de los espacios de color más comunes. Vemos como no son iguales, algunos como Adobe RGB meten muchos más verdes, otros como ProPhoto están girados respecto al resto. De hecho eso es una simplificación, ya que el "abanico de colores" de cada espacio en realidad debería representarse de forma tridimensional, dando como resultado una forma de ostra (o de cualquier otro molusco bivalvo).

Cuando miramos las especificaciones de un monitor, vemos que da un valor normalmente de 8bits por canal (24bits con un total de 16millones de colores), sin embargo viene también esa comparación con sRGB (en porcentaje) para saber cómo de coincidente es el color del monitor con el sRGB (que suele ser el espacio de color de referencia más habitual).

Los monitores TN durante mucho tiempo tuvieron sólo 6bits por canal (18bits y 262.144 colores) de forma que se inventaron el FRC (Frame Rate Control) que viene a ser como cuando pasabamos el dedo para difuminar, toma los valores de los puntos adyacentes para hacer una media, sacando así 2bits extra (6bits+2bits por canal>> 24bits). Explico esto del FRC porque ahora sigue usándose, no sólo en monitores TN, también en algunos VA e IPS, de forma que sacan 8bits+2bits por canal. ¿Por qué usar FRC si ya tienes 8bits por canal? Pues muy sencillo, porque el abanico se queda algo pequeños comparado con sRGB y el FRC ayuda a completarlo. De modo que el FRC nos ayuda a completar el sRGB, pero hace que no sea tan exacto, por lo que si nos dedicamos a labores de edición, siempre será mejor un buen panel de 8bits que uno más barato de 8bits+2bits (FRC).

Actualmente hay algunas tecnologías nuevas como Quantum Dot de Samsung que hacen que el monitor saque un 125% de sRGB con 8bits por canal, logrando imágenes muy coloridas y que el panel luzca espectacular, sin embargo para temas de edición no serían recomendables, puesto que perdemos precisión de color aunque intentáramos calibrar el monitor.

¿Realmente alguien usa algo más allá del sRGB y 24bits?

Bueno las gráficas "gaming" normalmente manejan sólo 24bits de modo que para la mayoría de gente no hay vida más allá de eso. Sin embargo existen monitores que exceden el sRGB y pasan a los 10bits por canal, denominándose "Wide Gamut" (que vendría a ser "gama amplia" o "gama ampliada") que son utilizados por profesionales de la edición fotográfica y de las artes gráficas (por ejemplo un editor de revista) y que valen un riñón. Básicamente vienen a cubrir entero (99-100%) de Adobe RGB y NTSC (un espacio que se usa en Japón y Norteamérica) e incluso llegan a superarlos. De hecho hay incluso espacios de 40bits y de 48bits que se usan en ciertas áreas y que tienen billones de colores (billones europeos, osea millones de millones)

¿Qué son los Quantum Dots (o QLED)?

Bien, esto es una tecnología propietaria de Samsung que viene a ofrecer un plus de viveza a los colores, llegando hasta el 125% sRGB creciendo sobre el lado de los rojos y los verdes... pero ¿cómo lo hacen? (hay que leerlo con la voz de narrador del Discovery Max)

Un monitor LED (que son la mayoría ahora mismo) su iluminación se produce con un panel de diodos led en su interior, que luego de pasar por varias capas convierte en puntos (pixels) de color. Para poder sacar luz blanca tiene que hacer una mezcla de leds rojos, verdes y azules... sin embargo para que ese blanco sea realmente blanco (y no amarillento) tiende a exagerar el color azul, lo cual limita un poco las gamas de colores rojo y verde (siempre el azul está "sobrecargado"). El Quantum Dots es una capa que permite mediante microcristales de fósforo (de nanómetros de tamaño) que la luz blanca no tenga que llevar ese exceso de azul, obteniendo unos subpixels rojos y verdes puros (sin tonalidades parásitas) que hace que todas los colores resulten mucho más cálidos y brillantes y tener esa ganancia de colores.

¿Qué es la tecnología NanoIPS de LG?

Pues básicamente LG ha seguido el mismo camino de Samsung, implementando una capa de "nanopartículas" (de ahí lo de NanoIPS) que como Quantum Dots permite obtener un mayor rango de colores en las gamas cromáticas verdes y rojas, llegando al 125% sRGB. La novedad con estos NanoIPS es que además incluirán iluminación local dimming lo que aproximará mucho a los paneles IPS respecto a los VA en cuanto a profundidad de negros, además de reducir al mínimo las fugas de luz (bleeding). Lo explicamos más a fondo en el siguiente apartado.

TIPOS DE ILUMINACIÓN DEL PANEL: FULL ARRAY, EDGE-LED, DIRECT LED, LOCAL DIMMING...

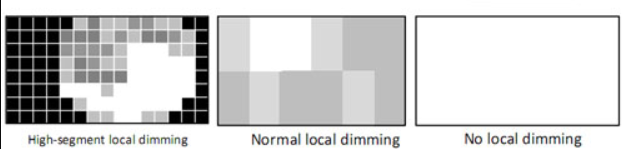

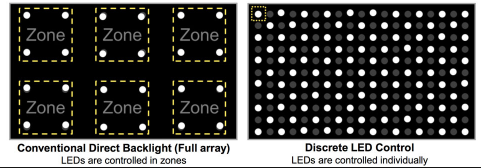

Como hemos visto los monitores se componen de diferentes capas, tanto en su interior (panel LCD, polarizadores, difusores...) como en su exterior (cristal, acabado mate/brillo... incluso capas de nano-partículas). Sin embargo poco hemos hablado de su iluminación, algo que había sido tan importante en la evolución desde los monitores de tubo a los monitores planos (el paso desde tubo catódico, pasando por los fluorescentes y llegando a los LED). Así que vamos manos a la obra... a ver si podemos dar unas pistas de las ventajas/desventajas de cada tipo de iluminación. En realidad vamos con años de retraso respecto a las TVs en temas de backlighting (iluminación), en parte porque el gran tamaño de las TVs actuales hace más fácil la implementación de diferentes tipos de iluminación, mientras que en monitores hemos estado años atascados en las 24"@1080p. Básicamente podemos diferenciar 3 tipos de iluminación LED que podemos ver en la imagen.

- Full Array: conlleva una malla densa de pequeños led dispuestos homogéneamente por todo el panel, que iluminan de forma más directa el panel. Ésto permite paneles más finos al tener una iluminación más directa... pero se lleva mejor con paneles de formatos grandes (de 27" en adelante)

- Edge-LED: los led tan sólo están dispuestos en los bordes, puede ser en sólo 2 bordes o en los 4 bordes. Son menos propensos a tener bleeding (fugas de luz) en las esquinas, pero a cambio tienen biseles más anchos. Es un tipo de iluminación que se usó mucho en las primeras generaciones de monitores LED y que ahora algunos fabricantes están volviendo a ellas (mejoradas).

- Direct LED: es una malla de led menos densa que los "Full-Array" y que necesitan una mayor distancia para que la luz se difumine de forma uniforme, dando paneles un poco más gruesos que los "full-array". Sin embargo es una tecnología que funciona bien a todas las escalas y por lo general da mejores resultados de uniformidad que los paneles Edge-LED.

Pero ésto sólo es la punta del iceberg... el local dimming supone la posibilidad de iluminar de forma diferencial el panel, haciendo que esa iluminación ya no sea homogénea y constante, sino que permita a los grupos de led emitir en función de la imagen que tienen encima... y cuanto más pequeños sean esos grupos, más exacta será esa iluminación (llegando hasta el extremo de los paneles OLED que cada pixel emite su propia luz). Esta iluminación por zonas nos va a aportar mayores contrastes, mejores negros, un mayor gradiente de grises... pero sobretodo supone un gran paso en la implementación de un HDR real como el que llevamos años teniendo en TVs. Veamos las diferentes nomenclaturas que relacionan el local dimming con el tipo de backlight.

- Discrete LED: se refiere a paneles donde el control de iluminación es LED a LED, con indiferencia de si son Full Array o si son Direct LED.

- FALD (Full Array Local Dimming): es un término acuñado por LG, estaríamos ante un panel completo (full array) y con un local dimming de multitud de zonas (la imagen de arriba es esquemática... esas zonas suelen ser desde grupos de 2x2 LED a grupos de 12x12 LED).

- Direct LED - Local Dimming: la iluminación es zonal, dando un resultado similar al dibujo que representa "normal local dimming". Mejora la experiencia al tener iluminación zonal, pero no alcanza la precisión de los FALD o Discrete LED. Aún así puede ser más que suficiente para monitores con certificados HDR400-HDR600.

- LED-Plus (EDGE-LED - Local Dimming): permite a los led de los laterales iluminar de forma diferencial, lo que genera esa iluminación en forma de cruces (de ahí el calificativo "plus" que identifica al símbolo + que genera esta iluminación). Es una solución relativamente barata para tener iluminación local dimming en paneles de tamaños contenidos... y muy posiblemente la vamos a ver con frecuencia en los próximos años en el mundillo de los monitores cogiendo popularidad.

**** Próximamente****