American Graffiti

Sombrerero Loco

- Registrado

- 23 Ene 2013

- Mensajes

- 5.488

- Puntos

- 113

Elegir un monitor durante muchos añOs ha sido algo trivial, sin embargo en los últimos años han evolucionado muchísimo y hoy por hoy esa elección es cada vez más clave, puesto que una correcta elección del mismo nos va a permitir sacar mayor partido a nuestro hardware y una mala elección provocará que no aprovechemos el potencial de nuestro equipo. Por eso es normal que cada vez demos más importancia al monitor e invirtamos más dinero en el monitor, bien porque estamos montando un potente equipo gaming, porque lo utilicemos para diseño/edición o para consumir contenidos multimedia.

En primer lugar, recomiendo la lectura de GUIA PRACTICA Monitores (ENERO 2016) donde el amigo @chetodann explica a la perfección la diferencia entre unos tipos de paneles y otros, algunas de las tecnologías, quien es cada fabricante, enlaces interesantes... En esta guía se volverán a comentar algunos temas, pero con menor profusión.

TIPOS DE PANEL

Su elección depende del uso que vayamos a darle al ordenador, pues las diferencias son notables entre unos y otros. Las principales diferencias las encontraremos a nivel de colores, ángulo de visión, tiempo de respuesta y contraste.

- Panel TN (o TN+Film): Son los paneles más básicos y destacan por su menor tiempo de respuesta (1ms GtG), por lo que son los favoritos para gaming, además de ser los más económicos. Por norma general carecen de gosthing y bleeding, dos defectos habituales en paneles IPS. Por contra su paleta de colores es más restrictiva (entorno al 7X% de sRGB) y los ángulos de visión son más restrictivos, de modo que los colores no son consistentes si no la vemos de frente.

- Panel VA (o PLS): Son paneles "todoterreno" que ofrecen unas características intermedias entre el TN y el IPS. Ofrecen un buen rango de colores (entorno al 9X% de sRGB), con buenos ángulos de visión y un tiempo de respuesta algo superior al TN (~4ms GtG), todo aderezado con un muy bien contraste, que da como resultados imágenes más vibrantes y negros más puros. Es una muy buena alternativa para gaming, pero nos permitirá editar con cierta precisión y destacan en consumo multimedia (películas, series, youtube...)

- Panel IPS: Son paneles más enfocados a diseño y edición, no sólo por su rango de colores superior al 95%, sino por su mayor precisión de color. Los tiempos de respuesta son algo más altos (5-7ms GtG) lo cuál puede ser un inconveniente para los jugadores más exigentes que estén acostumbrados a paneles TN, pero se puede jugar perfectamente con ellos. Tienen menor contraste que los VA y la sensación puede ser de colores un poco "lavados" en juegos y multimedia (en comparación con los VA). Para su uso en edición y diseño (incluído CAD/CAM) se recomienda ir a modelos de gamas media/alta por su mayor consistencia y precisión de colores.

RESOLUCIÓN DEL MONITOR

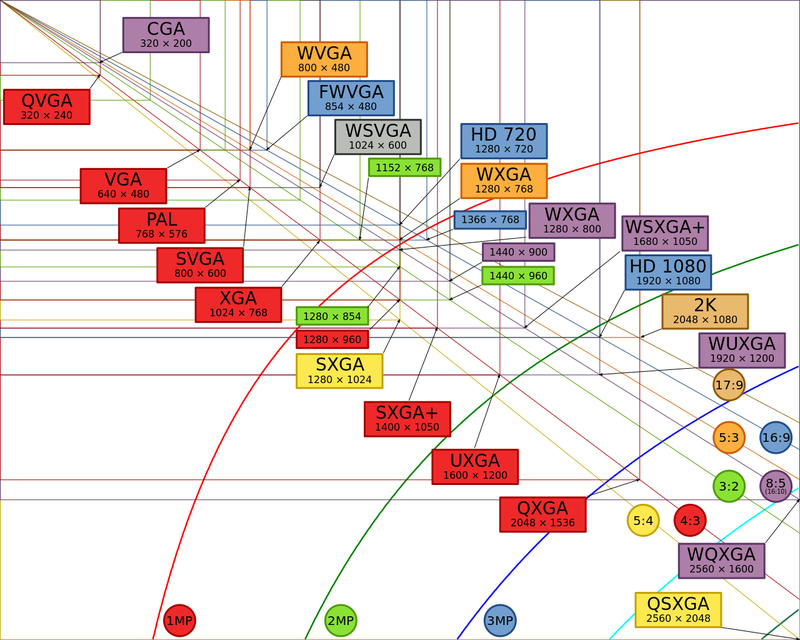

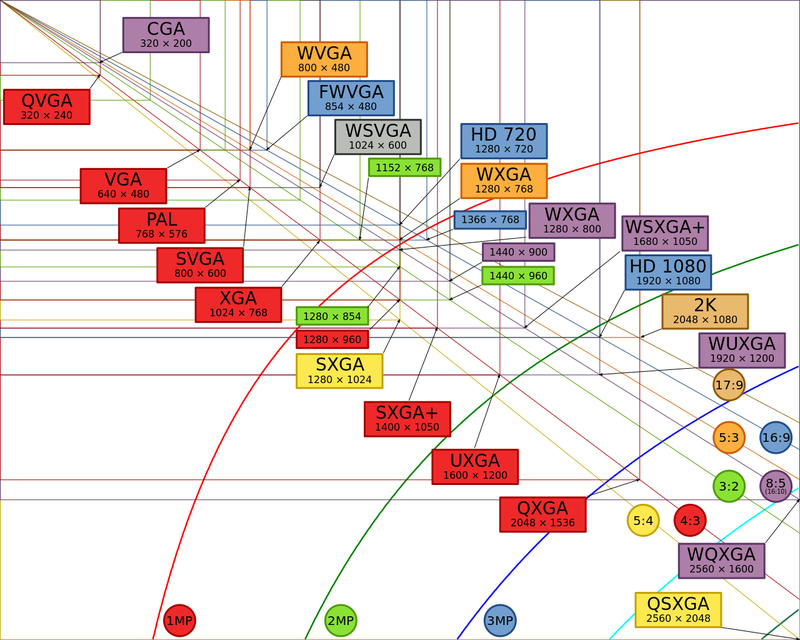

La resolución es la cantidad de pixels que vemos en pantalla y se suelen denominar por el número de pixels verticales (720p, 1080p, 1440p, 2160p...). Todas las resoluciones tienen una doble nomenclatura, que viene definida por entre 2-5 letras mayúsculas que son el acrónimo de dicha resolución, las cuales son algo más específicas, ya que nos indican también la proporción del monitor (normalmente 4:3, 16:9, 16:10 ó 21:9). De hecho es posible encontrar diferentes nomenclaturas (algunas basadas en VGA y otras en HD), además de tener siempre la posibilidad de nombrar los pixels horizontales y verticales (por ejemplo, 1080p / 1920x1080 / FHD / Full High Definition se refiernen exáctamente a lo mismo). Por simplicidad utilizaremos las nomenclaturas simplificadas (1080p / FHD) salvo que sea necesario especificar algo (explicación de las principales resoluciones en el spoiler).

DENSIDAD DE PIXELS

A veces nos obsesionamos mucho con la resolución cuando lo más interesante es la densidad y la densidad "aparente" (osea la que vamos a percibir a la distancia que solemos estar). La densidad se expresa como el número de pixels que hay en un cuadrado de una pulgada de lado y normalemente podemos encontrarla como dpi (dots per inch), ppi (pixels per inch) o ppp (puntos/pixels por pulgada).

Para Windows la densidad "estandar" son 92dpi y toda su interfaz (así como la de la mayoría de programas) están pensados para funcionar a dicha resolución. Windows incluye la posibilidad de escalar la interfaz, pero sólo hacia arriba para adaptarse a monitores de mayor dpi, de modo que si compras un monitor con resolución inferior a 92dpi corres el peligro de que todo se muestre demasiado grande (por ejemplo un 27" 1080p). En internet sin embargo la densidad "estandar" ha sido durante mucho tiempo 72dpi, de forma que las imágenes se ajustaban a dicha resolución, para mayor compatibilidad con los equipos antiguos y las conexiones lentas.

Para un mismo tamaño de pantalla, una mayor resolución (por ejemplo 1440p vs 1080p) nos va a aportar un mayor espacio de trabajo ya que los menús, barras de herramientas, iconos, etc... van a ser más pequeños, algo muy útil cuando trabajamos con programas de diseño y edición. Por contra para otros usos puede que ciertos elementos como los textos se vean más pequeños, lo cuál podemos mitigar con el escalado de Windows o con el escalado propio del programa si lo incluyera (como es el caso de Chrome).

En juegos, una mayor densidad nos aporta mucha más definición e información en pantalla y sobretodo suavidad en los contornos y bordes de los objetos, reduciendo el molesto efecto de "dientes de sierra". Normalmente para combatir ese efecto los juegos y programas utilizan una técnica conocida como "antialiasing", la cual supone una carga extra para nuestra tarjeta gráfica al aplicar pesados filtros para combatirlo.

Calcular la densidad puede ser algo tedioso si lo calculamos a mano, sin embargo hay webs que permiten calcularlo de forma sencilla e intuitiva. Yo personalmente recomiendo esta web

Calculadora de pixeles por pulgada (PPP)

DISTANCIA DE USO

Como ya adelantábamos en el apartado anterior, la distancia a la que vamos a estar del monitor es tan clave como su densidad. Si estamos muy cerca puede que lleguemos a ver los pixels y si estuvieramos muy lejos no seríamos capaces de discernir entre una resolución y su inmediatamente anterior. Es decir, cada monitor tiene una distancia óptima de visionado y unas distancias mínima y máxima, que si las calculamos nos ayudará a elegir mejor nuestro monitor y a sacarle el máximo provecho.

Esta relación entre densidad y distancia podríamos definirla como densidad aparente, siendo un valor aproximado y que dependerá también de nuestra sensibilidad a percibir diferencias de resolución. Yo utilizo una terna de valores que son 50-60-75 que por mi experiencia son bastante aproximados a las distancias mínima-optima-máxima respectivamente, medidas desde el ojo hasta el centro de la pantalla.

- Distancia óptima = 60 / dpi = distancia en metros

- Distancia mínima = 50 / dpi = distancia en metros

- Distancia máxima = 75 / dpi = distancia en metros

Del mismo modo podemos darle la vuelta a la ecuación para ver qué tal estamos situados ante nuestro monitor, comprobando así si la densidad aparente a dicha distancia es correcta.

- Distancia de visionado en metros * dpi = Densidad Aparente

¿Pasa algo si me encuentro más cerca de esa distancia mínima calculada? Pues posiblemente empieces a percibir la matriz de pixels del monitor, lo cual resulta bastante molesto. ¿Pasa algo si me encuentro a más distancia de la máxima calculada? Pues que posiblemente no seas capaz de diferenciar entre un vídeo 1080p y uno 720p.

¿Se cumple esto con la resolución 4K? La verdad que supone un salto tan grande de resolución que rompe un poco los esquemas, ya que nos daría unas distancias muy muy pequeñas, que en el uso real son un poco absurdas. Por ello utilizaremos los valores 60-75-90, una terna algo diferente de la utilizada para el resto de resoluciones, pero que da unos valores algo más aproximados a un uso real.

- Distancia óptima 4K = 75 / dpi = distancia en metros

- Distancia mínima 4K = 60 / dpi = distancia en metros

- Distancia máxima 4K = 80 / dpi = distancia en metros

De todas formas insisto en que son unos valores aproximados (con un margen de unos 5cm) y que dependen de cada uno, por lo que recomiendo sacar tus propios valores.

TAMAÑO, RESOLUCIÓN, DENSIDAD Y DISTANCIA DE USO

Como vemos los 4 valores van ligados de la mano. Una mejora en resolución nos puede permitir un salto a un monitor de mayor diagonal, incluso ganando densidad de pixels y por tanto pudiendo acercarnos más al monitor, teniendo una doble ganancia de espacio de trabajo, como sucede al pasar de un 24" 1080p a un 27" 1440p, que es un caso muy recurrente. Vamos a ver los casos más habituales:

Monitores 1080p >> Calculadas con 50-60-75

- Monitor 21,5" 1080p >> 102dpi >> distancia óptima 60cm / mínima 50cm / máxima 75cm

- UltraWide 25" 1080p >> 111dpi >> distancia óptima 55cm / mínima 45cm / máxima 70cm

- Monitor 24" 1080p >> 92dpi >> distancia óptima 65cm / mínima 55cm / máxima 85cm

- UltraWide 29" 1080p >> 96dpi >> distancia óptima 62,5cm / mínima 52,5cm / máxima 77,5cm

- Monitor 27" 1080p >> 81dpi >> distancia óptima 75cm / mínima 60cm / máxima 95cm

- UltraWide 34" 1080p >> 82dpi >> distancia óptima 75cm / mínima 60cm / máxima 95cm

- Monitor 32" 1080p >> 69dpi >> distancia óptima 85cm / mínima 72,5cm / máxima 110cm

Monitores 1440p >> Calculadas con 50-60-75

- Monitor 24" 1440p >> 123dpi >> distancia óptima 50cm / mínima 40cm / máxima 65cm

- Monitor 27" 1440p >> 109dpi >> distancia óptima 55cm / mínima 45cm / máxima 70cm

- Ultrawide 34" 1440p >> 109dpi >> distancia óptima 55cm / mínima 45cm / máxima 70cm

- Monitor 32" 1440p >> 92dpi >> distancia óptima 65cm / mínima 55cm / máxima 85cm

Monitor 2160p >> Calculadas con 60-75-90

- Monitor 24" 2160p >> 183dpi >> distancia óptima 42,5cm / mínima 32,5cm / máxima 50cm

- Monitor 28" 2160p >> 157dpi >> distancia óptima 45cm / mínima 37,5cm / máxima 57,5cm

- Monitor 32" 2160p >> 137dpi >> distancia óptima 55cm / mínima 45cm / máxima 65cm

- Monitor 40" 2160p >> 110dpi >> distancia óptima 70cm / mínima 55cm / máxima 85cm

En las imágenes podemos ver la comparativa entre los diferentes modelos de monitor y cómo afecta la resolución y la densidad de pixels en la distancia de uso y en los ángulos de visionado. Mientras que las distancias dependen únicamente de la densidad de pixels, los ángulos de visionado son una constante para cada una de las resoluciones (no dependen del tamaño del monitor). Ese valor del "ángulo de visionado" es lo que en juegos conocemos como FOV (field of view) y que suele ser ajustable en aquellos juegos de primera persona (principalmente shooters y carreras) de modo que aumenta la sensación de inmersión si ajustamos correctamente ese FOV.

Monitores FHD 16:9 >>> FOV 45º~50º

Monitores WFHD 21:9 >>> FOV 60~65º

Monitores QHD 16:9 >>> FOV 55~60º

Monitores WQHD 21:9 >>> FOV 70~80º

Monitores WQHD+ 21:9 >>> FOV 80-85º

Monitores UHD 16:9 >>> FOV 65-75º

Monitores 2xFHD >>> FOV 80-90º

Como utilidad para comparar tamaños de forma rápida y gráfica, me gusta recomendar la siguiente página Visual TV Size Comparison : Display Wars

En primer lugar, recomiendo la lectura de GUIA PRACTICA Monitores (ENERO 2016) donde el amigo @chetodann explica a la perfección la diferencia entre unos tipos de paneles y otros, algunas de las tecnologías, quien es cada fabricante, enlaces interesantes... En esta guía se volverán a comentar algunos temas, pero con menor profusión.

TIPOS DE PANEL

Su elección depende del uso que vayamos a darle al ordenador, pues las diferencias son notables entre unos y otros. Las principales diferencias las encontraremos a nivel de colores, ángulo de visión, tiempo de respuesta y contraste.

- Panel TN (o TN+Film): Son los paneles más básicos y destacan por su menor tiempo de respuesta (1ms GtG), por lo que son los favoritos para gaming, además de ser los más económicos. Por norma general carecen de gosthing y bleeding, dos defectos habituales en paneles IPS. Por contra su paleta de colores es más restrictiva (entorno al 7X% de sRGB) y los ángulos de visión son más restrictivos, de modo que los colores no son consistentes si no la vemos de frente.

- Panel VA (o PLS): Son paneles "todoterreno" que ofrecen unas características intermedias entre el TN y el IPS. Ofrecen un buen rango de colores (entorno al 9X% de sRGB), con buenos ángulos de visión y un tiempo de respuesta algo superior al TN (~4ms GtG), todo aderezado con un muy bien contraste, que da como resultados imágenes más vibrantes y negros más puros. Es una muy buena alternativa para gaming, pero nos permitirá editar con cierta precisión y destacan en consumo multimedia (películas, series, youtube...)

- Panel IPS: Son paneles más enfocados a diseño y edición, no sólo por su rango de colores superior al 95%, sino por su mayor precisión de color. Los tiempos de respuesta son algo más altos (5-7ms GtG) lo cuál puede ser un inconveniente para los jugadores más exigentes que estén acostumbrados a paneles TN, pero se puede jugar perfectamente con ellos. Tienen menor contraste que los VA y la sensación puede ser de colores un poco "lavados" en juegos y multimedia (en comparación con los VA). Para su uso en edición y diseño (incluído CAD/CAM) se recomienda ir a modelos de gamas media/alta por su mayor consistencia y precisión de colores.

RESOLUCIÓN DEL MONITOR

La resolución es la cantidad de pixels que vemos en pantalla y se suelen denominar por el número de pixels verticales (720p, 1080p, 1440p, 2160p...). Todas las resoluciones tienen una doble nomenclatura, que viene definida por entre 2-5 letras mayúsculas que son el acrónimo de dicha resolución, las cuales son algo más específicas, ya que nos indican también la proporción del monitor (normalmente 4:3, 16:9, 16:10 ó 21:9). De hecho es posible encontrar diferentes nomenclaturas (algunas basadas en VGA y otras en HD), además de tener siempre la posibilidad de nombrar los pixels horizontales y verticales (por ejemplo, 1080p / 1920x1080 / FHD / Full High Definition se refiernen exáctamente a lo mismo). Por simplicidad utilizaremos las nomenclaturas simplificadas (1080p / FHD) salvo que sea necesario especificar algo (explicación de las principales resoluciones en el spoiler).

Spoiler

Como se ve en la imagen, hay todo un popurrí de resoluciones y nomenclaturas, muchas de ellas en desuso, por lo que nos centraremos en las principales resoluciones usadas actualmente en portátiles y monitores.

Imagen de las principales resoluciones en nomenclatura VGA

Monitores Panorámicos

Se caracterizan por usar una proporción 16:9 que es el formato habitual de televisión. Los contenidos de cine suelen ser en 2,21:1 por lo que tendremos las características bandas negras.

- HD / 720p / HighDefinition / 1280x720 / 1366x768 / 1280x800 / 1280x768 / HD Ready: Como vemos la "alta definición" incluye todo un abanico de resoluciones y nomenclaturas, la mayoría de ellas utilizadas en portátiles y monitores, pero todas ellas son similares, por lo que se pueden englobar como 1280x720 ó 720p y se caracterízan por tener una proporción cercana al 16:9, aunque algunos tienden al 16:10 como 1280x800, mantienen como norma común tener una resolución cercana a 1 megapixel (1 millón de pixels)

- FHD / 1080p / 1920x1080 / Full High Definition : Es el estándar en cuanto a resolución, estando presente en monitores, televisores, portátiles, móviles... Mantiene una proporción 16:9, multiplicando x1,5 el número de pixels de 720p. Esta resolución es equivalente a los 2 megapixels (2 millones de pixels)

- WUXGA / 1200p / 1920x1200 : Es una variante de los FHD en la que ganamos algo en altura hasta una proporción 16:10. Son frecuentes en monitores destinados al sector profesional ya que permite tener un mayor espacio de trabajo.

- QHD / 1440p / 2560x1400 / 2K / Quad High Definition : Este formato amplia 1/3 la imagen del FHD tanto en vertical como en horizontal, ganando casi un 78% extra de espacio de trabajo. Por esta razón son muy indicados para su uso profesional, especialmente en trabajos de edición y diseño. Sin embargo su uso en gaming se está popularizando al mejorar la resolución en monitores grandes (principalmente de 27"). Multiplica x2 la resolución 720p (tanto en horizontal como en vertical) logrando una resolución equivalente a casi 4 megapixels (4 millones de pixels)

- UHD / 2160p / 3840x2160 / 4K / Ultra High Definition : Es el nuevo formato que se está extendiendo en televisores (y cámaras de vídeo) y que también está llegando a los monitores. Multiplica x2 la resolución 1080p (tanto en horizontal como en vertical) logrando una muy muy alta resolución, superior a los 8 megapixels (8 millones de pixels).

Monitores UltraPanorámicos (o Ultrawide)

Los conocidos como "ultrawide" son monitores 21:9, un formato más alargado que el 16:9 habitual. Un 25" ultrawide es equivalente a un 20", un 29" equivale a un 24" y un 34" equivale a un 27" (la equivalencia se refiere a la altura y densidad de pixels). Son una buena alternativa al uso de varios monitores ganando productividad en ámbitos profesionales. No todos los juegos admiten esta resolución debido a la ganancia de campo de visión (FOV), fundamentalmente en juegos "competitivos".

- WFHD / FHD+ / 2560x1080 / Wide Full High Definition / Ultrawide : Son una versión intermedia entre el FHD y el QHD, ya que toma el valor vertical de la primera y el valor horizontal de la segunda. Es habitual encontrarlo en formatos 25", 29" y 34". Es equivalente a unos 2,5 megapixels (2,5 millones de pixels)

- WQHD / QHD+ / 3440x1440 / Wide Quad High Definition : Es una versión de mayor resolución, partiendo de la resolución vertical del QHD y añadiendo 1/3 extra a lo ancho. Normalmente sólo es posible encontrarlo en 34" y son unos 5 megapixels (5 millones de pixels).

Productos Apple

La marca de la manzana como siempre suele ir por libre y utiliza normalmente sus propias resoluciones, con tendencia a la proporción 16:10 en portátiles. En este enlace se pueden ver las resoluciones utilizadas en algunos de los productos de Apple.

Imagen de las principales resoluciones en nomenclatura VGA

Monitores Panorámicos

Se caracterizan por usar una proporción 16:9 que es el formato habitual de televisión. Los contenidos de cine suelen ser en 2,21:1 por lo que tendremos las características bandas negras.

- HD / 720p / HighDefinition / 1280x720 / 1366x768 / 1280x800 / 1280x768 / HD Ready: Como vemos la "alta definición" incluye todo un abanico de resoluciones y nomenclaturas, la mayoría de ellas utilizadas en portátiles y monitores, pero todas ellas son similares, por lo que se pueden englobar como 1280x720 ó 720p y se caracterízan por tener una proporción cercana al 16:9, aunque algunos tienden al 16:10 como 1280x800, mantienen como norma común tener una resolución cercana a 1 megapixel (1 millón de pixels)

- FHD / 1080p / 1920x1080 / Full High Definition : Es el estándar en cuanto a resolución, estando presente en monitores, televisores, portátiles, móviles... Mantiene una proporción 16:9, multiplicando x1,5 el número de pixels de 720p. Esta resolución es equivalente a los 2 megapixels (2 millones de pixels)

- WUXGA / 1200p / 1920x1200 : Es una variante de los FHD en la que ganamos algo en altura hasta una proporción 16:10. Son frecuentes en monitores destinados al sector profesional ya que permite tener un mayor espacio de trabajo.

- QHD / 1440p / 2560x1400 / 2K / Quad High Definition : Este formato amplia 1/3 la imagen del FHD tanto en vertical como en horizontal, ganando casi un 78% extra de espacio de trabajo. Por esta razón son muy indicados para su uso profesional, especialmente en trabajos de edición y diseño. Sin embargo su uso en gaming se está popularizando al mejorar la resolución en monitores grandes (principalmente de 27"). Multiplica x2 la resolución 720p (tanto en horizontal como en vertical) logrando una resolución equivalente a casi 4 megapixels (4 millones de pixels)

- UHD / 2160p / 3840x2160 / 4K / Ultra High Definition : Es el nuevo formato que se está extendiendo en televisores (y cámaras de vídeo) y que también está llegando a los monitores. Multiplica x2 la resolución 1080p (tanto en horizontal como en vertical) logrando una muy muy alta resolución, superior a los 8 megapixels (8 millones de pixels).

Monitores UltraPanorámicos (o Ultrawide)

Los conocidos como "ultrawide" son monitores 21:9, un formato más alargado que el 16:9 habitual. Un 25" ultrawide es equivalente a un 20", un 29" equivale a un 24" y un 34" equivale a un 27" (la equivalencia se refiere a la altura y densidad de pixels). Son una buena alternativa al uso de varios monitores ganando productividad en ámbitos profesionales. No todos los juegos admiten esta resolución debido a la ganancia de campo de visión (FOV), fundamentalmente en juegos "competitivos".

- WFHD / FHD+ / 2560x1080 / Wide Full High Definition / Ultrawide : Son una versión intermedia entre el FHD y el QHD, ya que toma el valor vertical de la primera y el valor horizontal de la segunda. Es habitual encontrarlo en formatos 25", 29" y 34". Es equivalente a unos 2,5 megapixels (2,5 millones de pixels)

- WQHD / QHD+ / 3440x1440 / Wide Quad High Definition : Es una versión de mayor resolución, partiendo de la resolución vertical del QHD y añadiendo 1/3 extra a lo ancho. Normalmente sólo es posible encontrarlo en 34" y son unos 5 megapixels (5 millones de pixels).

Productos Apple

La marca de la manzana como siempre suele ir por libre y utiliza normalmente sus propias resoluciones, con tendencia a la proporción 16:10 en portátiles. En este enlace se pueden ver las resoluciones utilizadas en algunos de los productos de Apple.

DENSIDAD DE PIXELS

A veces nos obsesionamos mucho con la resolución cuando lo más interesante es la densidad y la densidad "aparente" (osea la que vamos a percibir a la distancia que solemos estar). La densidad se expresa como el número de pixels que hay en un cuadrado de una pulgada de lado y normalemente podemos encontrarla como dpi (dots per inch), ppi (pixels per inch) o ppp (puntos/pixels por pulgada).

Para Windows la densidad "estandar" son 92dpi y toda su interfaz (así como la de la mayoría de programas) están pensados para funcionar a dicha resolución. Windows incluye la posibilidad de escalar la interfaz, pero sólo hacia arriba para adaptarse a monitores de mayor dpi, de modo que si compras un monitor con resolución inferior a 92dpi corres el peligro de que todo se muestre demasiado grande (por ejemplo un 27" 1080p). En internet sin embargo la densidad "estandar" ha sido durante mucho tiempo 72dpi, de forma que las imágenes se ajustaban a dicha resolución, para mayor compatibilidad con los equipos antiguos y las conexiones lentas.

Para un mismo tamaño de pantalla, una mayor resolución (por ejemplo 1440p vs 1080p) nos va a aportar un mayor espacio de trabajo ya que los menús, barras de herramientas, iconos, etc... van a ser más pequeños, algo muy útil cuando trabajamos con programas de diseño y edición. Por contra para otros usos puede que ciertos elementos como los textos se vean más pequeños, lo cuál podemos mitigar con el escalado de Windows o con el escalado propio del programa si lo incluyera (como es el caso de Chrome).

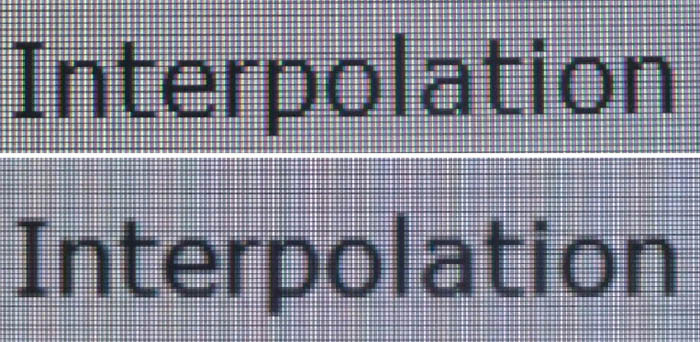

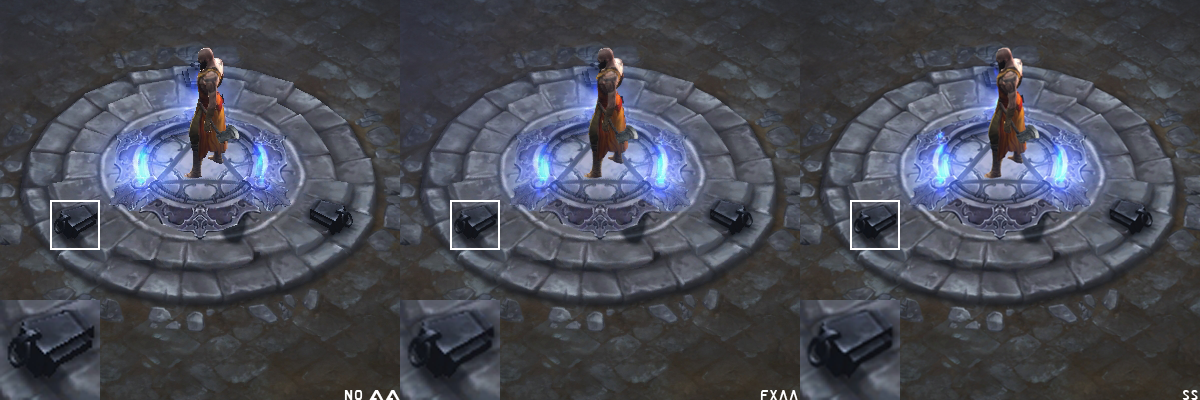

En juegos, una mayor densidad nos aporta mucha más definición e información en pantalla y sobretodo suavidad en los contornos y bordes de los objetos, reduciendo el molesto efecto de "dientes de sierra". Normalmente para combatir ese efecto los juegos y programas utilizan una técnica conocida como "antialiasing", la cual supone una carga extra para nuestra tarjeta gráfica al aplicar pesados filtros para combatirlo.

Calcular la densidad puede ser algo tedioso si lo calculamos a mano, sin embargo hay webs que permiten calcularlo de forma sencilla e intuitiva. Yo personalmente recomiendo esta web

Calculadora de pixeles por pulgada (PPP)

DISTANCIA DE USO

Como ya adelantábamos en el apartado anterior, la distancia a la que vamos a estar del monitor es tan clave como su densidad. Si estamos muy cerca puede que lleguemos a ver los pixels y si estuvieramos muy lejos no seríamos capaces de discernir entre una resolución y su inmediatamente anterior. Es decir, cada monitor tiene una distancia óptima de visionado y unas distancias mínima y máxima, que si las calculamos nos ayudará a elegir mejor nuestro monitor y a sacarle el máximo provecho.

Esta relación entre densidad y distancia podríamos definirla como densidad aparente, siendo un valor aproximado y que dependerá también de nuestra sensibilidad a percibir diferencias de resolución. Yo utilizo una terna de valores que son 50-60-75 que por mi experiencia son bastante aproximados a las distancias mínima-optima-máxima respectivamente, medidas desde el ojo hasta el centro de la pantalla.

- Distancia óptima = 60 / dpi = distancia en metros

- Distancia mínima = 50 / dpi = distancia en metros

- Distancia máxima = 75 / dpi = distancia en metros

Del mismo modo podemos darle la vuelta a la ecuación para ver qué tal estamos situados ante nuestro monitor, comprobando así si la densidad aparente a dicha distancia es correcta.

- Distancia de visionado en metros * dpi = Densidad Aparente

¿Pasa algo si me encuentro más cerca de esa distancia mínima calculada? Pues posiblemente empieces a percibir la matriz de pixels del monitor, lo cual resulta bastante molesto. ¿Pasa algo si me encuentro a más distancia de la máxima calculada? Pues que posiblemente no seas capaz de diferenciar entre un vídeo 1080p y uno 720p.

¿Se cumple esto con la resolución 4K? La verdad que supone un salto tan grande de resolución que rompe un poco los esquemas, ya que nos daría unas distancias muy muy pequeñas, que en el uso real son un poco absurdas. Por ello utilizaremos los valores 60-75-90, una terna algo diferente de la utilizada para el resto de resoluciones, pero que da unos valores algo más aproximados a un uso real.

- Distancia óptima 4K = 75 / dpi = distancia en metros

- Distancia mínima 4K = 60 / dpi = distancia en metros

- Distancia máxima 4K = 80 / dpi = distancia en metros

De todas formas insisto en que son unos valores aproximados (con un margen de unos 5cm) y que dependen de cada uno, por lo que recomiendo sacar tus propios valores.

TAMAÑO, RESOLUCIÓN, DENSIDAD Y DISTANCIA DE USO

Como vemos los 4 valores van ligados de la mano. Una mejora en resolución nos puede permitir un salto a un monitor de mayor diagonal, incluso ganando densidad de pixels y por tanto pudiendo acercarnos más al monitor, teniendo una doble ganancia de espacio de trabajo, como sucede al pasar de un 24" 1080p a un 27" 1440p, que es un caso muy recurrente. Vamos a ver los casos más habituales:

Monitores 1080p >> Calculadas con 50-60-75

- Monitor 21,5" 1080p >> 102dpi >> distancia óptima 60cm / mínima 50cm / máxima 75cm

- UltraWide 25" 1080p >> 111dpi >> distancia óptima 55cm / mínima 45cm / máxima 70cm

- Monitor 24" 1080p >> 92dpi >> distancia óptima 65cm / mínima 55cm / máxima 85cm

- UltraWide 29" 1080p >> 96dpi >> distancia óptima 62,5cm / mínima 52,5cm / máxima 77,5cm

- Monitor 27" 1080p >> 81dpi >> distancia óptima 75cm / mínima 60cm / máxima 95cm

- UltraWide 34" 1080p >> 82dpi >> distancia óptima 75cm / mínima 60cm / máxima 95cm

- Monitor 32" 1080p >> 69dpi >> distancia óptima 85cm / mínima 72,5cm / máxima 110cm

Monitores 1440p >> Calculadas con 50-60-75

- Monitor 24" 1440p >> 123dpi >> distancia óptima 50cm / mínima 40cm / máxima 65cm

- Monitor 27" 1440p >> 109dpi >> distancia óptima 55cm / mínima 45cm / máxima 70cm

- Ultrawide 34" 1440p >> 109dpi >> distancia óptima 55cm / mínima 45cm / máxima 70cm

- Monitor 32" 1440p >> 92dpi >> distancia óptima 65cm / mínima 55cm / máxima 85cm

Monitor 2160p >> Calculadas con 60-75-90

- Monitor 24" 2160p >> 183dpi >> distancia óptima 42,5cm / mínima 32,5cm / máxima 50cm

- Monitor 28" 2160p >> 157dpi >> distancia óptima 45cm / mínima 37,5cm / máxima 57,5cm

- Monitor 32" 2160p >> 137dpi >> distancia óptima 55cm / mínima 45cm / máxima 65cm

- Monitor 40" 2160p >> 110dpi >> distancia óptima 70cm / mínima 55cm / máxima 85cm

En las imágenes podemos ver la comparativa entre los diferentes modelos de monitor y cómo afecta la resolución y la densidad de pixels en la distancia de uso y en los ángulos de visionado. Mientras que las distancias dependen únicamente de la densidad de pixels, los ángulos de visionado son una constante para cada una de las resoluciones (no dependen del tamaño del monitor). Ese valor del "ángulo de visionado" es lo que en juegos conocemos como FOV (field of view) y que suele ser ajustable en aquellos juegos de primera persona (principalmente shooters y carreras) de modo que aumenta la sensación de inmersión si ajustamos correctamente ese FOV.

Monitores FHD 16:9 >>> FOV 45º~50º

Monitores WFHD 21:9 >>> FOV 60~65º

Monitores QHD 16:9 >>> FOV 55~60º

Monitores WQHD 21:9 >>> FOV 70~80º

Monitores WQHD+ 21:9 >>> FOV 80-85º

Monitores UHD 16:9 >>> FOV 65-75º

Monitores 2xFHD >>> FOV 80-90º

Como utilidad para comparar tamaños de forma rápida y gráfica, me gusta recomendar la siguiente página Visual TV Size Comparison : Display Wars

Última edición: